Avant-propos

Les publications scientifiques étant exclusivement en anglais, je fais en sorte de laisser les mots clés en anglais et de donner des explications en français (je ne sais même pas si certains mots ont une traduction en français). Le but étant que vous puissiez après lire de vous-même n’importe quelle publication ou article de vulgarisation en anglais sur le sujet et les comprendre.

Le domaine du NLP évoluant actuellement très rapidement il m’est impossible de présenter tous les nouveaux modèles par manque de temps. D’où là encore la nécessité que vous alliez consulter certaines sources anglophones par vous-même.

Un élément qui me semble important pour pouvoir comprendre n’importe quelle publication est de connaître les tâches qui servent à comparer les performances des différents modèles ainsi que les jeux de données test en lien avec ces tâches.

La présentation des jeux de données anglophones se base sur l’article de Lilian Weng (travaillant chez OpenAI). Merci à elle de m’avoir autorisé à effectuer cette traduction.

Celle des jeux de données francophones se base sur la publication de l’équipe ayant développé le modèle CamemBERT, sur la publication de l’équipe ayant développé le modèle FlauBERT, sur la publication de l’équipe ayant développé FQuAD et mes propres recherches.

La librairie Dataset

En 2020, l’entreprise Hugging Face a dévoilé sa librairie Dataset (anciennement nlp).

Grâce à celle-ci vous pouvez charger en une ligne de code l’un des 900 jeux de données (français et autres langues) actuellement disponible sur la librairie (chiffre datant de mai 2021). Vous trouverez sur cette librairie, la plupart des jeux de données présentés dans les paragraphes qui suivent.

Pour connaître les jeux de données disponibles, vous pouvez consulter leur application Streamlit, et pour un tutoriel d’utilisation, vous pouvez consulter le Collab suivant.

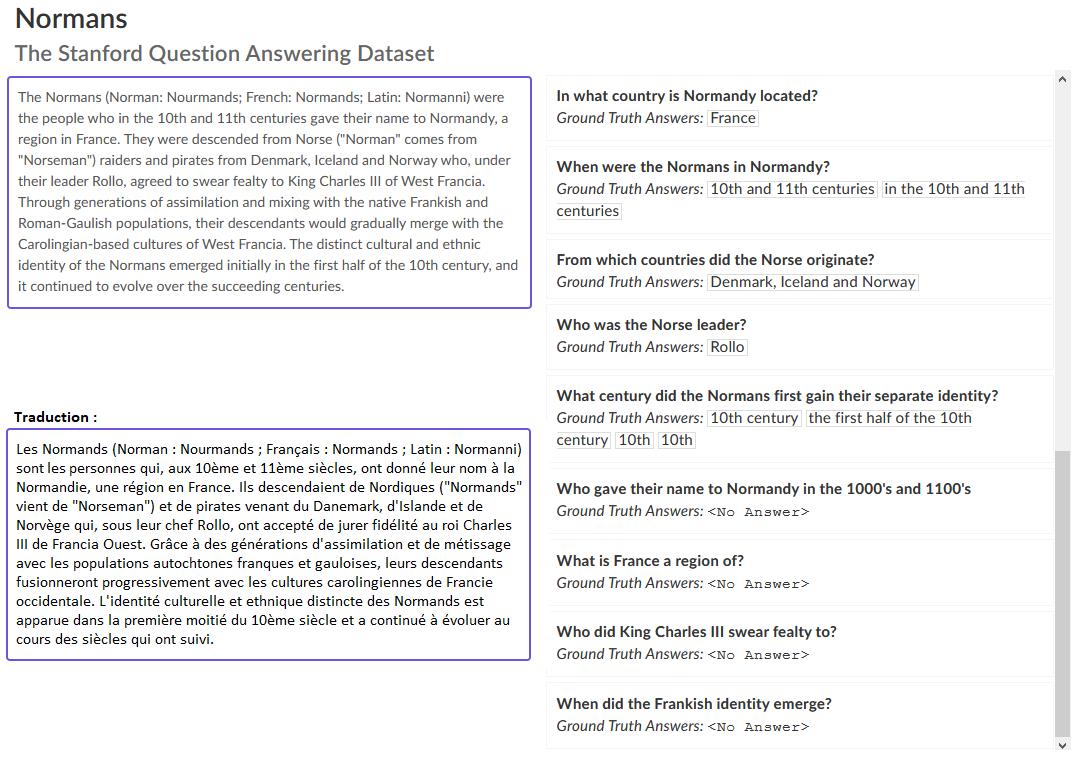

Question-Answering (Questions/Réponses)

Le modèle doit répondre à une série de questions en lien avec un jeu de données test. Certaines questions peuvent ne pas avoir de réponses. Exemple :

Les jeux de données anglophones communs :

- SQuAD (Stanford Question Answering Dataset) de Rajpurkar et al. pour la version 1 et Rajpurkar et al. pour la version 2. Il s’agit d’un jeu de données sur la compréhension de la lecture, composé de questions posées sur un ensemble d’articles de Wikipédia, où la réponse à chaque question est un intervalle de texte.

- RACE (ReAding Comprehension from Examinations) de Lai, Xie et al.. Il s’agit d’un jeu de données sur la compréhension de la lecture comprenant plus de 28 000 passages et près de 100 000 questions. Le dataset provient d’examens d’anglais en Chine, qui sont conçus pour les élèves du collège et du lycée.

Pour le français :

- FQuAD de l’entreprise Illuin Technology (plus particulièrement Hoffschmidt et al.) qui se base sur la méthodologie de SQUAD 1.0. Elle contient plus de 25.000 questions/réponses basées sur des articles de qualité de Wikipédia. Pour plus d’informations concernant la répartition des types de questions (qui ? quoi ? où ? quand ?, etc…), la répartion des entités (noms communs, personnes, lieu, etc…) et les résultats des premiers benchmarks basés sur CamemBERT et FlauBERT, je vous invite à lire la publication de l’équipe d’Illuin Technology.

- le projet PIAF (Pour une IA Francophone) porté par Etalab et plus particulièrement Keraron et al.. Les données de PIAF sont accessibles librement ici.

A l’exception de FQUADv2 de Heinrich et al, les jeux de données en français se basent sur la méthodologie de SQUAD 1.0. Ainsi la base de données a été conçue de telle sorte qu’à chaque question posée, la réponse est trouvable dans le texte. SQUAD 2.0 introduit des questions dont la réponse ne se trouve pas dans le texte. Cela permet au modèle d’apprendre également la possibilité : « la réponse n’est pas dans le texte » ou bien « je ne sais pas » au lieu de vouloir coute que coute répondre quelque chose.

- Mkqa est un jeu de données multilingues avec une partie en français. Il est proposé par Longpre et al.

Jeu de données de questions/anwsering où la réponse peut être à choix multiples :

- Base à cheval entre les questions/réponses et le raisonnement : disaster_response_messages. Dans cette base multilingue ayant une partie en français, un texte est fourni avec des questions associées. Les réponses à ces questions étant exclusivement « oui » ou « non ».

- La base Exams de Hardalov et al. est une base multilingue ayant une partie en français, un texte est fourni avec des questions associées. Cinq réponses sont proposées à ces questions. Les textes étant des QCM pour des lycéens.

Commonsense Reasoning (Raisonnement)

Parmi un choix de propositions (souvent entre 2 et 4), le modèle doit choisir laquelle est la plus vraisemblable étant donné le texte fournit en entrée. Exemple :

| Texte | Proposition 1 (la plus vraisemblable) | Proposition 2 |

| Gina a égaré son téléphone chez ses grands-parents. Il n’était nulle part dans le salon. Elle a réalisé qu’elle était dans la voiture avant. Elle a pris les clés de son père et est sortie en courant. | Elle a trouvé son téléphone dans la voiture. | Elle ne voulait plus son téléphone. |

Les jeux de données anglophones communs :

- Story Cloze Test de Mostafazadeh et al. : sert à évaluer le raisonnement au niveau de la compréhension et la génération des histoires. Le test exige qu’à partir de deux options, un système choisisse la fin correcte à des histoires développées sur plusieurs phrases.

- SWAG (Situations With Adversarial Generations) de Zellers et al. : choix multiples ; contient 113 000 exemples de paires de phrases qui évaluent les inférences fondées sur le bon sens.

Pour le français :

- Possibilité d’utiliser la partie en français de la base multilingues Conceptnet5 de Speers et al. (fait peu commun, la base en français est plus grande que l’anglaise).

Natural Language Inference (NLI)

Peut être également rencontré dans la littérature sous le nom de Text Entailment. Il s’agit d’un exercice pour discerner en logique si une phrase peut être déduite d’une autre.

Les jeux de données anglophones communs :

- RTE (Recognizing Textual Entailment) : un ensemble de jeux de données initiés par des défis de Text Entailment.

- SNLI (Stanford Natural Language Inference) de Young et al. : une collection de 570 000 de phrases en anglais écrites par l’homme à la main. Elles sont étiquetées à la main pour une classification équilibrée des labels entailment, contradiction, et neutral.

- MNLI (Multi-Genre NLI) de Williams et al. : semblable à SNLI, mais avec une plus grande variété de styles de texte et de sujets, recueillis à partir de transcriptions de discours, de fictions populaires et de rapports gouvernementaux.

- QNLI (Question NLI) : convertion de SQuAD en une tâche de classification binaire des paires de la forme (question, phrase).

- SciTail de Khot et al : un jeu de données créé à partir d’examens scientifiques à choix multiples et de phrases sur le Web.

Pour le français :

- vous pouvez utiliser la partie francophone du jeu de données XNLI (même auteurs que SNLI),

- ou bien, utiliser FLUE (French Language Understand-ing Evaluation).

FLUE est l’équivalent francophone de GLUE (cf. Benchmark multi-tâches de l’article). Il a été crée par Le et al. les auteurs de FlauBERT. En pratique, la partie NLI de FLUE est la partie francophone du jeu de données XNLI évoqué au point précédent. Utiliser l’un ou l’autre revient donc au même. L’intérêt de FLUE est qu’il regroupe plusieurs tâches.

Named Entity Recognition (NER) (Reconnaissance d’entités nommées)

Etiquette les séquences de mots d’un texte qui sont des noms de choses (personnes, sociétés, gènes, protéines, etc.).

Les jeux de données anglophones communs :

- CoNLL 2003 NER task : consiste en un flux d’informations émanant de Reuters, se concentrant sur quatre types d’entités nommées : les personnes, les lieux, les organisations et les noms d’entités diverses.

- OntoNotes 5.0 de Weischedel et al. : ce corpus contient des textes en anglais, arabe et chinois, avec quatre types d’entités différents (personne, lieux, organisation, noms d’entités diverses).

- Reuters Corpus de Lewis et al. : une grande collection d’articles de Reuters.

Pour le français :

- le FTB (French Treebank) crée par les équipes de l’Université Paris-Diderot (laboratoire LLF et notamment Abeillé et al) contenant plus de 21 550 phrases provenant d’articles du journal Le Monde publiés entre 1989 et 1995. L’accès à cette base de données est cependant restreint. Pour y avoir accès, il faut en effectuer la demande.

- la partie en français de la base Wikiner disponible ici de Nothman et al..

- Wikiann de Rahimi et al. basé sur Pan, Xiaoman, et al. qui permet de faire du transfert de NER entre plusieurs langues.

Sentiment Analysis (Analyse de sentiments)

Le modèle doit classer correctement un texte (positif, négatif, etc…).

Les jeux de données anglophones communs :

- SST (Stanford Sentiment Treebank) de Socher et al. : contient 215 154 phrases labellisées basées sur 11 855 phrases de critiques de films.

- IMDb de Maas et al. : un grand jeu de données de critiques de films avec des étiquettes binaires de classification des sentiments.

Pour le français :

- FLUE met à disposition le jeu de données CLS-FR. Celui-ci est composé d’avis d’utilisateurs de trois types de produits proposés sur Amazon : livres, musiques et DVD (4000 avis pour chacun des types de produits). Il permet de faire de la classification multi-classes.

- dans la même logique que le point précédent, le corpus The Multilingual Amazon Reviews Corpus de Keung et al. propose des avis de client issue d’Amazon. Cependant ce corpus multilingue propose beaucoup plus d’avis pour le français (environ 200 000) et sur des données plus récentes que celles de FLUE.

- Google propose une base multilingue binaire intégrant du français (il faut dire si une phrase est négative ou positive) : Senti_lex

- WiLI_2018 de Martin Thoma propose 1000 phrases à classer pour les 235 langues proposées.

- Aspect-Based Sentiment Analysis in French de Apidianaki et al. contient 457 avis de restaurants (2365 phrases) et 162 de musées (655 phrases).

- Un jeu de données binaire scrapé sur AlloCiné par Blard propose plus de 200.000 critiques de films à classer en « positive » ou « négative ».

Semantic Role Labeling (SRL)

Modélise la structure prévisible d’un argument d’une phrase. Peut être vu comme une réponse à la question « Qui a fait quoi à qui ».

En anglais :

En français :

Pas d’équivalent en français à l’heure actuelle à ma connaissance.

Sentence similarity

Cette tâche consiste à déterminer dans quelle mesure deux textes sont similaires. Cela peut se faire en attribuant une note de 1 à 5. Les tâches connexes sont la paraphrase ou l’identification des doublons.

En anglais :

- MRPC (MicRosoft Paraphrase Corpus) : contient des paires de phrases extraites de sources d’information sur le Web, avec des annotations indiquant si chaque paire est sémantiquement équivalente.

- QQP (Quora Question Pairs) STS Benchmark de Iyer et al. : consiste en plus de 400 000 paires de questions issues du site Quora.

Pour le français :

- FLUE met à disposition la partie en français de PAWS-X de Zhang et al., soit environ 49 000 données d’apprentissage et 2 000 de test.

- TaPaCo de Scherrer est une base de paraphrases portant sur 73 langues incluant une partie en français.

- La base de données REFreSD de Briakou et Carpuat est de la sentence similarity mais entre deux langues : l’anglais et le français. Une phrase est donnée en anglais puis une autre en français. Le modèle doit dire si la phrase en français est liée à l’anglais ou pas.

Sentence Acceptability

Annotation des phrases pour qu’elles soient grammaticalement acceptables. Les jeux de données anglophones communs :

En anglais :

- CoLA (Corpus of Linguistic Acceptability) de Warstadt et al. : classification binaire de phrases.

En français :

Pas d’équivalent en français à l’heure actuelle à ma connaissance

Part-of-Speech (POS) Tagging

Consiste à attribuer à chaque mot sa catégorie grammaticale correspondante. L’analyse des dépendances consiste à prédire l’arbre syntaxique capturant les relations syntaxiques entre les mots.

En anglais :

- Universal Dependencies (UD) (les contributeurs) : contient plus de 100 banques d’arbres dans plus de 60 langues

- Ritter et al. : issues de l’analyse de social medias anglais.

En français :

Huit banques d’arbres sont disponibles gratuitement dans UD v2.2 :

- GSD (données provenant de blogs, d’articles de presse, de critiques et de Wikipedia) de De Marneffe et al.,

- Sequoia de Candito et al. (contient plus de 3000 phrases provenant du journal régional L’Est Républicain, Wikipédia et des documents de l’agence européenne de la médecine),

- Spoken de Lacheret et al.,

- ParTUT (conversion de données multilingues émanant de l’Université de Turin) de Bosco et Sanguinetti.

La simplification de textes

Les modèles de simplification de texte permettent de conserver le sens de la phrase mais avec une syntaxe différente et souvent plus courte. Deux approches sont envisageables. La première où le texte original est paraphrasé. La deuxième consiste à faire un résumé du texte original.

Simplification par paraphrase

En anglais :

- Asset de Alva-Manchego, Martin et al. permet de finetuner les modèles de simplification de texte.

En français :

- Le jeu de données ALECTOR de Gala et al. contient des extraits de sites proposant du matériel pédagogique pour les niveaux CE1, CE2 et CM1 de l’école primaire. Chaque texte original a été adapté (simplifié) au niveau du lexique (vocabulaire), de la morpho-syntaxe (catégories grammaticales, structures de phrase) et du discours (co-référence).

- MUSS de Martin et al. porte sur un outil permettant une simplification de phrases multilingues.

Simplification par résumé

Dans cette approche, nous avons le texte original en entrée et un résumé de ce texte en sortie.

En anglais :

En français :

- Orange_sum de Eddine et al. introduite avec leur modèle BARThez, consistant en des résumés d’articles du site orange news.

- la partie en français de la base de données multilingues MLSUM de Scialom et al..

- WikiLingua de Ladhak et al. propose une base multilingue contenant une partie en français consistant à faire des résumés d’articles de WikiHow.

- Cette base des résumés d’articles de journaux français

Machine Translation (Traduction automatique)

Tâche qui consiste à traduire une phrase dans une langue donnée dans une autre langue.

Le site Manythings contient plus de 80 paires de langues de la forme anglais/seconde_langue. Le couple Anglais/Français contient pour plus de 175 623 paires de phrases.

Il existe d’autres corpus Anglais/Français. On peut par exemple citer : le WMT14, le WMT20, les données de Pytorch ou encore celles de ParaPat de Soares et al.

Pour des corpus français/Seconde_langue avec Seconde_langue différente de l’Anglais, il y a énormément (+ de 50) de jeux de données européens disponibles à l’adresse suivante : http://opus.nlpl.eu/index.php. On accède aux différents jeux de données en cliquant sur les liens tout en haut de la page.

Quelques exemples de textes trouvables :

- Ecb : textes traduits en plusieurs langues de rapports de la banque centrale européenne

- Emea : textes traduits en plusieurs langues de rapports de l’agence européenne du médicament

- Euronews : textes traduits en plusieurs langues de la chaine d’information Euronews

Et pleins d’autres choses comme des traductions de livres, de la constitution, de la déclaration des droits de l’homme, des sous-titres de TED, etc.

Microsoft propose également un jeu de données de textes techniques pouvant être utilisée pour développer des versions localisées d’applications qui s’intègrent aux produits Microsoft. Elle peut également être utilisée pour intégrer la terminologie Microsoft dans d’autres collections terminologiques ou servir de glossaire informatique de base pour le développement linguistique dans les quelque 100 langues disponibles.

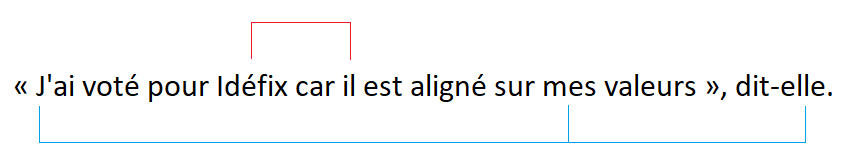

Coreference Resolution

Associe les parties d’un texte qui se réfèrent aux mêmes notions. Exemple :

En anglais :

En français :

- La partie francophone par Candito el al. de la base multilingues PARSEME.

Long-range Dependency

Les jeux de données anglophones communs :

- LAMBADA (LAnguage Modeling Broadened to Account for Discourse Aspects) de Paperno et al.. C’est une collection de passages narratifs extraits de BookCorpus (voir section suivante). La tâche est de prédire le dernier mot (ce qui nécessite au moins 50 tokens de contexte pour qu’un humain puisse prédire avec succès).

- Children’s Book Test de Wetson et al. est construit à partir de livres qui sont librement disponibles dans le Projet Gutenberg. La tâche consiste à prédire le mot manquant parmi 10 candidats.

En français :

Pas d’équivalent en français à l’heure actuelle à ma connaissance.

Jeux de données pour l’entraînement

Les jeux de données anglophones communs :

- Books corpus : Le corpus contient « plus de 7 000 livres non publiés de genres variés, dont l’Aventure, la Fantaisie et la Romance ».

- 1B Word Language Model Benchmark

- English Wikipedia : ~2500M words

Les jeux de données utilisés par CamemBERT et FlauBERT :

- OSCAR d’Ortiz Suárez et al.

- Common Crawl

- la page 8 de la publication de FlauBERT pour connaître les jeux de données qu’ils ont utilisés.

Benchmark multi-tâches

Les benchmarks anglophones :

- GLUE multi-task benchmark de Wang et al.

- decaNLP benchmark de Mcann et al.

Les benchmarks francophones : - FLUE

- XGLUE version multilingue de GLUE ayant une partie en français de Liang et al.

Références

- SQuAD: 100,000+ Questions for Machine Comprehension of Text de Rajpurkar et al. (2016)

- Know What You Don’t Know: Unanswerable Questions for SQuAD de Rajpurkar et al. (2018)

- RACE: Large-scale ReAding Comprehension Dataset From Examinations de Lai, Xie et al. (2017)

- FQuAD: French Question Answering Dataset de Hoffschmidt et al. (2020)

- Project PIAF: Building a Native French Question-Answering Dataset de Keraron et al. (2020)

- FQuAD2.0: French Question Answering and knowing that you know nothing de Heinrich et al. (2021)

- MKQA: Multilingual Knowledge Questions & Answers de Longpre et al. (2020)

- EXAMS: A Multi-subject High School Examinations Dataset for Cross-lingual and Multilingual Question Answering de Hardalov et al. (2020)

- A Corpus and Evaluation Framework for Deeper Understanding of Commonsense Stories de Mostafazadeh et al. (2016)

- SWAG: A Large-Scale Adversarial Dataset for Grounded Commonsense Inference de Zellers et al. (2018)

- ConceptNet 5.5: An Open Multilingual Graph of General Knowledge de Speers et al. (2016)

- SciTaiL: A Textual Entailment Dataset from Science Question Answering de Khot et al. (2018)

- A Broad-Coverage Challenge Corpus for Sentence Understanding through Inference de Williams et al. (2018)

- From image descriptions to visual denotations: New similarity metrics for semantic inference over event descriptions de Young et al. (2014)

- FlauBERT: Unsupervised Language Model Pre-training for French de Le et al. (2019)

- RCV1:A New Benchmark Collection for Text Categorization Research de Lewis et al. (2004)

- OntoNotes Release 5.0 de Weischedel et al. (2013)

- Building a treebank for French de Abeillé et al. (2000)

- Learning multilingual named entity recognition from Wikipedia de Nothman et al. (2013)

- Massively Multilingual Transfer for NER de Rahimi et al. (2019)

- Massively Multilingual Transfer for NER de Pan, Xiaoman, et al. (2019)

- Recursive Deep Models for Semantic CompositionalityOver a Sentiment Treebank de Socher et al. (2013)

- Learning Word Vectors for Sentiment Analysis de Maas et al. (2011)

- The Multilingual Amazon Reviews Corpus de Keung et al. (2020)

- Datasets for Aspect-Based Sentiment Analysis in French de Apidianaki et al. (2016)

- The WiLI benchmark dataset for written language identification de Martin Thoma (2018)

- French sentiment analysis with BERT de Blard (2020)

- First Quora Dataset Release: Question Pairs de Iyer et al. (2016)

- PAWS: Paraphrase Adversaries from Word Scrambling de Zhang et al. (2019)

- TaPaCo: A Corpus of Sentential Paraphrases for 73 Languages de Scherrer (2020)

- Detecting Fine-Grained Cross-Lingual Semantic Divergences without Supervision by Learning to Rank de Briakou et Carpuat (2020)

- Neural Network Acceptability Judgments de Warstadt et al. (2018)

- Rhapsodie: a Prosodic-Syntactic Treebank for Spoken French de Lacheret et al. (2014)

- Named Entity Recognition in Tweets: An Experimental Study de Ritter et al. (2011)

- PartTUT: The Turin University Parallel Treebank de Bosco et Sanguinetti (2014)

- Teaching Machines to Read and Comprehend de Hermann et al. (2015)

- ASSET: A Dataset for Tuning and Evaluation of Sentence Simplification Models with Multiple Rewriting Transformations de Alva-Manchego, Martin et al (2020)

- Alector: A Parallel Corpus of Simplified French Textswith Alignments of Misreadings by Poor and Dyslexic Readers de Gala et al. (2020)

- MUSS: Multilingual Unsupervised Sentence Simplification by Mining Paraphrases de Martin et al. (2020)

- Don’t Give Me the Details, Just the Summary! Topic-Aware Convolutional Neural Networks for Extreme Summarization de Narayan et al. (2018)

- BARThez: a Skilled Pretrained French Sequence-to-Sequence Model de Eddine et al. (2020)

- MLSUM: The Multilingual Summarization Corpus de Scialom et al. (2020)

- WikiLingua: A New Benchmark Dataset for Cross-Lingual Abstractive Summarization de Ladhak et al. (2020)

- The LAMBADA dataset: Word prediction requiring a broad discourse context de Paperno et al. (2016)

- Towards AI-Complete Question Answering: A Set of Prerequisite Toy Tasks de Wetson et al. (2015)

- A Monolingual Approach to Contextualized Word Embeddings for Mid-Resource Languages de Ortiz Suárez et al. (2020)

- GLUE: a Multitasks Benchmark and Analysis Platform for Natural Language Understanding de Wang et al. (2019)

- The Natural Language Decathlon: Multitask Learning as Question Answering de Mcann et al. (2018)

- XGLUE: A New Benchmark Dataset for Cross-lingual Pre-training, Understanding and Generation de Liang et al. (2020)

Citation

@inproceedings{tasks_and_datasets_nlp_blog_post,

author = {Loïck BOURDOIS},

title = {Tâches et jeux de données fréquemment utilisés dans les publications de NLP},

year = {2020},

url = {https://lbourdois.github.io/blog/nlp/Taches-et-jeux-de-donnees-en-NLP/}

}